估计不少网友都有接触过“AI绘图”带来的乐趣,随着软件科技水平的发展,这种以前只能在专业影视剧制作中才会用到的技术,目前已经是“大众化”被许多网友广泛运用。

目前,网络上存在着许多“AI绘图”的技术软件及功能,有的只需要用户简单上传几张图片,就能实现“AI换脸”功能。

然而,因为这个技术的大众化普及,以至于被一些网友运用到满足自我癖好,将其运用在一些不道德甚至非法的用途中去。

近日,据报道广东广州一女子在地铁上的照片被AI一键脱衣,其照片被网友进行“AI绘图”一键转换成了“不雅照”传播引发网友热议及愤怒。

据悉,该名女子穿着的是正常的体恤和短裤,却被人“一键脱衣”并且将照片在网络上疯传,可想而知这名女子的心理阴影有多大。

在网友深扒之下,网友们寻找到地铁女子当事人,她是某平台的一位女博主,这张照片也只是她分享的日常生活照,照片本身并无任何问题。

网友们表示现在造谣的成本也太低了,随便找一张照片在网络上找到相关AI软件进行“一键转换”就能毁掉一个人。

科技技术不应该被用在这上面,而滥用技术的人也必须付出相应的代价。

“鼠标一点,你的衣服就脱光了”,AI技术的进步,造谣的成本越来越低,效果却是越来越真。

这是我们普通人都有可能遇到的问题,并且让被造谣者“百口莫辩”。

网友们表示,若是这样的技术太过于普遍,对于女孩子们来说可能就连坐个地铁都不再“安全”了。

若是被人在地铁中随便拍张照片,利用AI软件就能制造出“不雅照”,这令人实在是感到后怕。

前段时间小编有些过某短视频博主利用抠图换脸视频技术,将影视剧中女明星的与男主角的亲密镜头转换成自己。

由于他的行为激怒了该女明星的粉丝,导致多位20多岁的粉丝根据其作品定位,找到其工作室将其抓伤。

当时就有网友表示,这项技术若是用在普通的女孩子身上,简直是细思极恐。

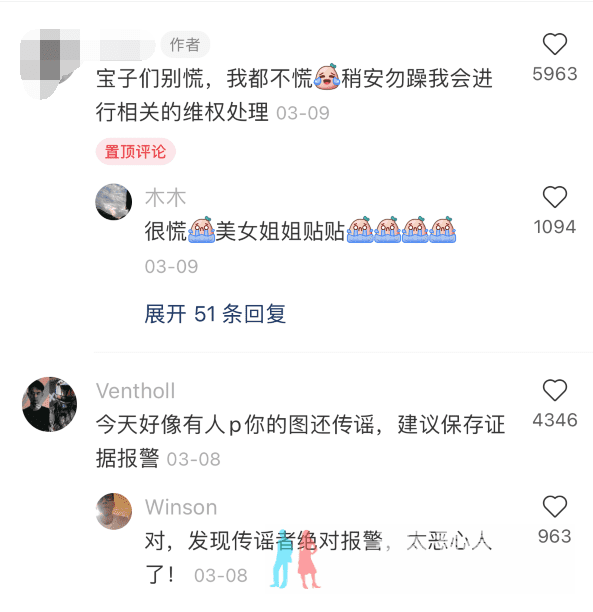

事件当事人在收到网友的评论后表示,让粉丝们别慌自己会进行相关的维权处理。

此次广州地铁女子事件,法律相关人士表示进行制作传播者涉嫌违反网络安全法相关规定。

相关部门可以对其进行罚款等相关措施,并且当事人可以对其侵犯肖像权、侮辱、诽谤等行为,要求对行为人提出行政处罚甚至是刑事处罚,并且也可以通过民事诉讼方式提出赔偿。